آرس تكنيكا

تتحرك الأشياء بسرعة البرق في AI Land. يوم الجمعة ، أنشأ مطور برمجيات يُدعى جورجي جيرغانوف أداة تسمى “llama.cpp” والتي يمكنها تشغيل نموذج لغة AI الكبير الجديد فئة GPT-3 من Meta ، LLaMA ، محليًا على كمبيوتر محمول Mac. بعد فترة وجيزة ، عمل الناس كيفية تشغيل LLaMA على الويندوز أيضا. لذلك شخص ما أظهرها وهي تعمل على هاتف Pixel 6 ، ثم جاء a Raspberry Pi (على الرغم من أنه يدور ببطء شديد).

إذا استمر هذا الأمر ، فقد ننظر إلى منافس الجيب ChatGPT قبل أن نعرفه.

لكن دعنا نعود لمدة دقيقة ، لأننا لم نصل إلى هناك بعد. (على الأقل ليس اليوم ، كما هو الحال اليوم حرفياً ، 13 مارس 2023.) لكن ما سيحدث الأسبوع المقبل ، لا أحد يعلم.

منذ إطلاق ChatGPT ، شعر بعض الأشخاص بالإحباط بسبب القيود المضمنة في نموذج الذكاء الاصطناعي التي تمنعه من مناقشة الموضوعات التي اعتبرتها OpenAI حساسة. هكذا بدأ حلم-في بعض الدوائر – نموذج لغة كبير مفتوح المصدر (LLM) يمكن لأي شخص تشغيله محليًا دون رقابة ودون دفع رسوم واجهة برمجة التطبيقات لـ OpenAI.

توجد حلول مفتوحة المصدر (مثل GPT-J)، لكنهم يتطلب الكثير من ذاكرة الوصول العشوائي GPU ومساحة التخزين. لا يمكن للبدائل الأخرى مفتوحة المصدر أن تتباهى بأداء مستوى GPT-3 على أجهزة المستهلك المتاحة بسهولة.

أدخل LLaMA ، وهو LLM متاح بأحجام معلمات تتراوح من 7B إلى 65B (أي “B” كما في “بلايين المعلمات” ، وهي أرقام فاصلة عائمة مخزنة في مصفوفات تمثل ما “يعرفه” النموذج). قدمت LLaMA ادعاءًا مقنعًا: أن نماذجها الأصغر يمكن أن تتطابق مع OpenAI’s GPT-3 ، النموذج الأساسي الذي يدعم ChatGPT ، من حيث جودة وسرعة إنتاجه. كانت هناك مشكلة واحدة فقط – أصدرت Meta شفرة LLaMA مفتوحة المصدر ، لكنها حجبت “الأوزان” (“المعرفة” المدربة المخزنة في شبكة عصبية) للباحثين المؤهلين فقط.

تطير بسرعة LLaMA

لم تستمر قيود Meta على LLaMA طويلاً ، لأنه في 2 مارس ، شخص ما فقدان الوزن LLaMA على BitTorrent. منذ ذلك الحين ، حدث انفجار في التطوير حول LLaMA. باحث الذكاء الاصطناعي المستقل سايمون ويليسون بالنسبة إلى هذا الموقف مع إصدار Stable Diffusion ، وهو نموذج تجميع صور مفتوح المصدر تم إطلاقه في أغسطس الماضي. وهذا ما كتبه في مقال على مدونته:

أشعر أن لحظة الانتشار المستقر في أغسطس أثارت موجة جديدة كاملة من الاهتمام بالذكاء الاصطناعي التوليدي ، والذي دفع بعد ذلك إلى أقصى الحدود بإصدار ChatGPT في أواخر نوفمبر.

تحدث لحظة البث المستقر هذه مرة أخرى في الوقت الحالي ، بالنسبة لنماذج اللغات الكبيرة ، التكنولوجيا التي تقف وراء ChatGPT نفسها. قمت هذا الصباح بتشغيل نموذج لغة فئة GPT-3 على جهاز الكمبيوتر المحمول الشخصي الخاص بي لأول مرة!

كانت عناصر الذكاء الاصطناعي غريبة بالفعل. إنها على وشك أن تصبح أغرب بكثير.

عادةً ما يتطلب تشغيل GPT-3 العديد من وحدات معالجة الرسومات A100 من فئة مراكز البيانات (أيضًا ، أوزان GPT-3 ليست عامة) ، ولكن LLaMA جعلت الموجات لأنها يمكن أن تعمل على GPU واحد عام سمين. والآن ، مع التحسينات التي تقلل حجم النموذج باستخدام تقنية تسمى التكميم ، يمكن تشغيل LLaMA على Mac M1 أو أقل من وحدة معالجة الرسومات Nvidia الرئيسية.

تتغير الأمور بسرعة كبيرة بحيث يصعب أحيانًا مواكبة آخر التطورات. (بالنسبة لمعدل تقدم الذكاء الاصطناعي ، قال صحفي زميل في منظمة العفو الدولية لـ Ars ، “إنها مثل مقاطع الفيديو الخاصة بكلاب حيث تقوم بإلقاء صندوق كرات التنس عليها. [They] لا أعرف أي طريقة للبحث أولاً وتضيع في الارتباك. “)

على سبيل المثال ، فيما يلي قائمة بالأحداث البارزة المتعلقة بـ LLaMA استنادًا إلى ملف تقويم أوضح ويليسون في تعليق على أخبار القراصنة:

- 24 فبراير 2023: أعلنت Meta AI عن LLaMA.

- 2 مارس 2023: شخص ما تسريبات نماذج LLaMA من خلال BitTorrent.

- 10 مارس 2023: جورجي جيرجانوف إنشاء llama.cppوالتي يمكن تشغيلها على جهاز Mac M1.

- 11 مارس 2023: قام Artem Andreenko بأداء LLaMA 7B (ببطء) على Raspberry Pi 44 جيجا بايت رام ، 10s / token.

- 12 مارس 2023: LLaMA 7B يعمل على NPX ، أداة وقت تشغيل node.js.

- 13 آذار (مارس) 2023: حصل شخص ما على llama.cpp يعمل على هاتف Pixel 6أيضا ببطء شديد.

- 13 مارس 2023 و 2023: إصدارات ستانفورد الألبكة 7 بنسخة مُحسَّنة من التعليمات من LLaMA 7B “تتصرف بشكل مشابه لـ” text-davinci-003 “الخاص بـ OpenAI ولكنها تعمل على أجهزة أقل قوة بكثير.

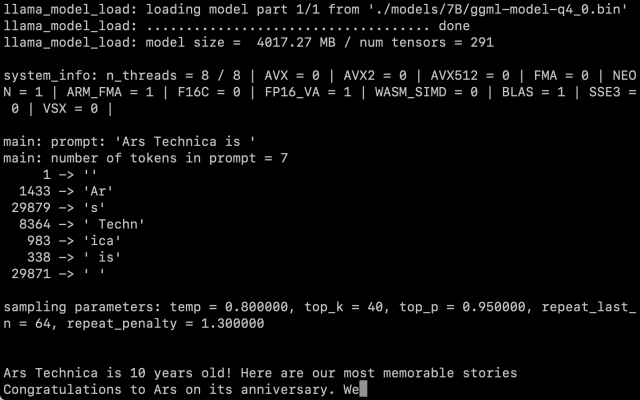

بعد الحصول على أوزان LLaMA بأنفسنا ، اتبعنا تعليمات Willison وقمنا بتشغيل إصدار إعدادات 7B على Macbook Air M1 ، وهو يعمل بسرعة معقولة. يمكنك استدعاءه كبرنامج نصي في سطر الأوامر مع موجه ، ويبذل LLaMA قصارى جهده لإنهائه بطريقة معقولة.

بنج إدواردز / آرس تكنيكا

يبقى السؤال حول كيفية تأثير التكميم على جودة المخرجات. في اختباراتنا ، كان LLaMA 7B الذي تم تقليصه إلى 4 بت تكميمًا مثيرًا للإعجاب لتشغيله على MacBook Air ، ولكن لا يزال غير مطابق تمامًا لما قد تتوقعه من ChatGPT. من الممكن تمامًا أن تؤدي تقنيات الحوافز الأفضل إلى نتائج أفضل.

أيضًا ، تكون عمليات التحسين والتعديل سريعة عندما يكون لدى الجميع الكود والأوزان ، على الرغم من أن LLaMA لا تزال تكافح مع بعض مقيدة للغاية شروط الاستعمال. ال نزهة الألبكة اليوم من قبل ستانفورد يثبت أن الضبط الدقيق (تدريب إضافي مع وضع هدف محدد في الاعتبار) يمكن أن يحسن الأداء ، ولا يزال الوقت مبكرًا بعد إصدار LLaMA.

حتى كتابة هذه السطور ، لا يزال تشغيل LLaMA على جهاز Mac بمثابة تمرين تقني تمامًا. تحتاج إلى تثبيت Python و Xcode وأن تكون على دراية بعمل سطر الأوامر. ويليسون جيد تعليمات خطوه بخطوه لمن يريد تجربتها. لكن هذا قد يتغير قريبًا مع استمرار المطورين في البرمجة.

أما بالنسبة للآثار المترتبة على وجود هذه التكنولوجيا في البرية ، فلا أحد يعرف حتى الآن. بينما يقلق البعض بشأن تأثير الذكاء الاصطناعي كأداة لإرسال الرسائل غير المرغوب فيها والمعلومات المضللة ، يقول ويليسون ، “لن يتم اختلاقها ، لذا أعتقد أن أولويتنا يجب أن تكون إيجاد أكثر الطرق البناءة الممكنة لاستخدامها.”

في الوقت الحالي ، ضماننا الوحيد هو أن الأمور ستتغير بسرعة.

“Social media addict. Zombie fanatic. Travel fanatic. Music geek. Bacon expert.”

/cloudfront-us-east-2.images.arcpublishing.com/reuters/XGACEPLMIJI3VEZYOZZTI22EJI.jpg)